文\蔡宗桓

大型語言模型(LLM)可能會編造出錯誤事實的現象被稱為“產生幻覺”(Hallucination),而它們至今也還無法區分事實和虛構,這讓許多企業懷疑使用它們是否值得冒險。由美國麻省理工學院量子計算實驗室分拆出來的人工智慧新創公司Cleanlab創建的一項新工具,則是旨在讓高風險用戶更清楚地了解這些模型的可信度。

眾所周知,AI(人工智能)目前還是會因為“幻覺”而產生胡言亂語的現象,例如稍早前Google推出的AI──Overviews胡言亂語的回答便引起各地網民的討論,許多網民更分享自己在使用Google AI Overviews時所得到的搞笑回覆,其中包括“在醬汁中加入無毒膠水,以增加披薩的黏性”、“狗在NBA打過球”這類荒謬答案。

AI有時會提供一些匪夷所思的答案的情況,開始讓用戶對於人工智慧所提供的搜索結果的信任度下降。為此,麻省理工學院量子電腦實驗室成員成立的AI新創Cleanlab便開發一款“可信度語言模型(Trustworthy Language Model)”,它能為大型語言模型生成內容的可信度打分數,分數越接近0意味着可信度越低,分數越接近1則可信度越高,而這將有助用戶判斷有關資訊是否可信。

Cleanlab執行長Curtis Northcutt說,他們希望這項工具能降低企業對大型語言模型的擔憂,並進而對AI產興趣。

“人們都知道大型語言模型將改變世界,只是目前他們都對它的幻覺問題感到相當困擾。”

可信度語言模型使用多種技術來計算分數。當用戶向它詢問問題時,它會把這個問題與自己所生成的內容同步傳送給多個大型語言模型,包括OpenAI的GPT系列模型、AI公司Databricks開發的模型DBRX等,如果它們提供的回應相似,那麼,最終將獲得較高分數。

它還會把生成內容的關鍵字替換成具有相同含義的詞語,再傳送給每一個模型。如果它們皆對同義詞有相似回應,也將能獲得高分。

Northcutt解釋說:“我們用不同的方式來測試這些模型,並觀察它們提供的答覆是否一致。”

此外,可信度語言模型也能讓多個模型相互交流,我們可以想像它們會有這樣的對話:“這是我的答案,你覺得如何?”而這樣的交流過程也會受到監控與測量,並被納入評分考量中。

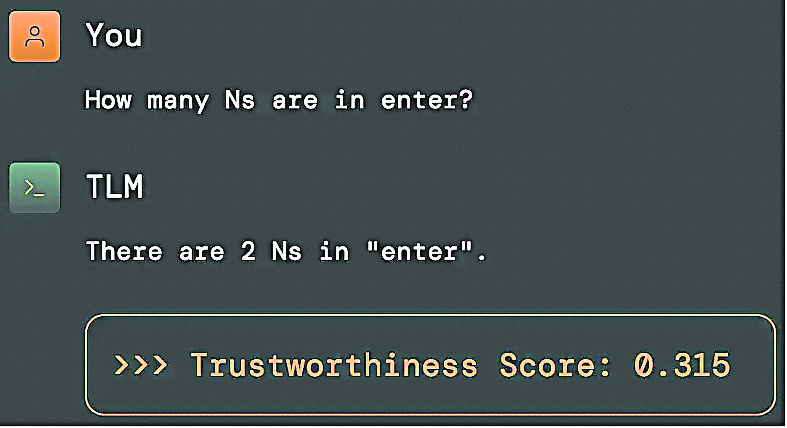

早前,Cleanlab實際展示了可信度語言模型的成果。Northcutt首先問ChatGPT:“enter這個詞中出現了多少個n?”

在前幾次的詢問下,ChatGPT皆能給出正確解答,但後幾次它開始隨機提供錯誤答案。接下來,Northcutt向可信度語言模型詢問同樣的問題時,它回稱:“在單字enter中,字母n出現了2次。”並給出了0.315的分數。

Northcutt說:“我們可以看到這並不是一個很高的分數,意即我們不該完全信任聊天機器人提供的答覆。”

這是一項簡單的測試,卻直指目前大型語言模型普遍存在的問題。Northcutt說,如果沒有可信度分數,人們或會相信聊天機器人提供的所有資訊,並因此作出錯誤的決策。

雖然可信度語言模型的運作成本較高,但Cleanlab將此視為一種進階服務,他們並非要取代聊天機器人,而是要分擔人類專家的工作。

Northcutt說,如果這款工具能讓用戶省下付給資深經濟學家或律師每小時2000美元(約9415令吉)起跳的費用,那麼,使用它時所須付出的成本便是值得的。

不過,長遠來看,Northcutt還是希望可信度語言模型能降低民眾對大型語言模型的擔憂,並看見它們的發展潛力。

媒體研究AI與記者合作方式

去年,生成式AI的興起,衝擊許多內容創作產業,在好萊塢還曾因此引發美國編劇工會(WGA)發動罷工運動,而同樣以內容產製為主要技能的另一項產業──新聞媒體,也已經開始學習把生成式AI視為開啟新商業模式的工具。

目前已有多家新聞編輯室如《紐約時報》、《美聯社》等,都與科技公司合作或投入資源研究,並希望可以找出AI工具與記者之間的最佳協作方式。

雖然用戶只須餵養生成式AI一些對話,如“幫我寫一則關於XXX事件的新聞”,並給予相關資料,AI就可以洋洋灑灑地寫出一篇報導,但若沒有新聞媒體人員根據新聞事實產製的“原生內容”, AI又該從何學習到這些新聞事實,繼而寫出報導呢?

換句話說,科技公司在訓練模型時,勢必需要吸取大量新聞內容作為學習素材,所以,數家媒體巨頭便依此方向與科技公司商議,並認為科技公司應該要繳點“學費”。

據《金融時報》報導,媒體大亨梅鐸旗下的新聞集團(News Corp)、《紐約時報》集團、英國《衛報》等媒體集團近期都與至少一家科技巨頭圍繞着“版權費”的定價和收費方式討論了初步合作的可能性。

《美聯社》則已於去年與OpenAI達成為期2年的協議,並將利用OpenAI技術和產品的專業知識來探索新聞產品和服務應用生成式AI的使用案例。

與此同時,OpenAI在未來2年內也能以《美聯社》選定的新聞內容來訓練AI模型,而有關內容甚至可以追溯至1985年的新 聞。

至於在組織內部的運用,英國第二大區域性和地方報紙出版商《新聞探尋》(Newsquest)去年也在全英國多處新聞編輯室聘請了“AI輔助”記者。他們的工作主要是運用以ChatGPT為基礎打造的內部文案寫作工具,輸入必要的事實內容,如議會會議紀錄等,再讓該工具把它轉化為新聞內容。

該報社旗下的《伍斯特新聞》的編輯普里斯(Stephanie Preece)指出,當AI可以輔助記者產出基本的文章架構後,記者便可以挪出寫稿時間去旁聽法庭、與議員寒暄建立關係,或參加更多線下活動,再回頭把AI寫成的新聞脈絡補充得更完整,同時也有更多時間進行查核,以減少資訊錯誤的問題。

“AI無法在車禍現場、法庭上、議會會議上感受新聞當事人的情緒,且無法判斷受訪者是否在說謊。”

普里斯說:“這些都需要記者親自去做,而AI只能協助釋放出記者的精力和時間。”

日研發健康電子湯匙

為不加鹽食物添鹹味

全世界的發明無奇不有,但你能想到《搞笑諾貝爾獎》(Ig Nobel Prize)的得獎的發明真的也要商業化販售了嗎?

意在“表揚那些先讓人為之一笑,而後引人深思的成就”的《搞笑諾貝爾獎》的去年得主之一的共同推手日商──麒麟(該研究為日本明治大學與麒麟共同研發)首度把獲獎發明──電子湯匙的概念商業化。

麒麟預計本月通過一間零售商獨家販售定價1萬9800日圓(約593令吉)的電子湯匙,且將限量200個。同時,這間日本飲料巨頭也對此湯匙寄予厚望,不只把海外銷售計劃訂於明年啟售,更期待在未來5年內於全球獲得超過100萬名用戶的支持。

麒麟研究員佐藤愛(Ai Sato)指出,日本的飲食文化偏好鹹味,日本成年人平均每天的鹽攝取量約為10克,為世界衛生組織建議攝取量的兩倍之多。因此,日本人需要減少鹽的攝入量,而這電子湯匙便能在不增加額外鈉的狀況下增強食物的鹹味,且得以在不影響飲食習慣的情況下,促使用戶健康飲食。這也是促使麒麟致力使這款電子湯匙得商業化量產的主要因素。

這款電子湯匙是麒麟與明治大學教授宮下芳明(Miyashita)共同開發。宮下教授先前在電子湯匙的原型概念上展示了增強味覺的效果,即通過從湯匙傳遞微弱的電場,將鈉離子分子集中在舌頭上,進而促成增強食物鹹味的效果。

在麒麟與明治大學共同開發之前,這些概念始於宮下教授與當時正在就讀研究所的東京大學專案助理教授中村 (Nakamura)的電味(Electric Taste)研究。研究核心即為當微弱的電流通過舌頭時,例如人們舔乾電池時,便會感受到一股獨特的味道,而這樣的“電味”已被用於檢測味覺障礙。

2011年,這群研究員發表一篇論文,其中指出食物與飲料的味道會因為電子筷子或吸管而改變。其後,他們便運用這套知識基礎開發利用電刺激技術,讓人們可在不使用鹽的食物中也感受到強烈的味道。

結合研究基礎,宮下教授與麒麟公司合作開發出這款重量60克,由塑膠與金屬製成,並通過可充電式鋰電池供電的電子湯匙。

麒麟正從傳統的啤酒、飲料業務轉向健康飲食領域發展,而麒麟也表明,這項技術之於日本有着特殊意義,且盼能通過電子湯匙的商業化,助日本人改善嗜鹹味的飲食習慣,並逐漸走向健康養生的目標。

滿足年輕讀者需要

挪威公司

利用AI劃新聞重點

挪威最大的公共廣播公司NRK把AI工具用於挽救它逐漸流失的年輕讀者。該公司發現,年輕世代的讀者的閱讀習慣傾向簡單易懂的“摘要”,於是,NRK編輯創新主管豪根(Ida Anna Haugen)便運用AI為每篇文章新增重點摘要,讓讀者能一眼就看出新聞的重點,再決定是否值得深入閱讀。

《新聞探尋》的AI主管多爾蒂-科夫(Jody Doherty-Cove)認為,AI很快就會被廣泛應用於新聞編輯室,“就像是網絡協助記者找到資訊並創造更豐富的故事,而AI也提供類似的工具。”

新聞媒體和AI公司展開合作似乎是自然而然的發展,但科技公司如何確保新聞內容的版權價值,以及新聞媒體如何使用AI技術,並在提升新聞產出效率的同時確保一定的新聞品質,這都是未來新聞編輯室裡相互碰撞出更多火花後,值得大家深思的議題。